使用 XAI Control 将 GitHub Models 的免费模型接入任何应用

GitHub 推出的 GitHub Models。它提供了一系列强大的 AI 模型 API,如 openai/gpt-4o、xai/grok-3-mini 等,并且 "Free to use" (免费使用)。

然而,这些免费模型存在 速率限制 (Rate limits),这可能成为您应用扩展的瓶颈。同时,您可能希望在自己的脚本、自动化流程、或像 LobeChat、NextChat 这样的第三方客户端里统一使用这些模型。

XAI Control 完美地解决了这些问题。它充当一个强大的“云 AI 路由”,不仅能将您对 GitHub Models 的访问权限转换成标准的 OpenAI API 接口,更能通过其核心的负载均衡设计,帮助您轻松突破速率限制。

核心优势:

- 统一 API 接口: 将 GitHub Models 无缝集成到任何支持 OpenAI API 的工具或应用中。

- 突破速率限制: 通过多密钥轮询实现负载均衡,将调用上限轻松翻倍。

- 高可用性: 当某个密钥失效或达到限速时,系统自动切换到下一个可用密钥,保证服务不中断。

- 企业级管理: 享受 XAI Control 带来的统一密钥管理、安全防护和成本控制等强大功能。

第一步:获取多个 GitHub Personal Access Token (PAT)

为了实现负载均衡,我们需要准备多个 GitHub 账户。

- 登录您的 GitHub 账户。

- 点击右上角头像,进入 Settings。

- 在左侧菜单底部,找到并点击 Developer settings。

- 选择 Personal access tokens -> Tokens (classic)。

- 点击 Generate new token -> Generate new token (classic)。

- Note: 给你的令牌起一个描述性的名字,如

xai-key-1。 - Expiration: 选择一个合适的有效期。

- Select scopes: 不需要勾选任何权限。

- 点击页面底部的 Generate token。

- 重要: 立即复制生成的令牌(以

ghp_开头)并妥善保管。 - 重复以上步骤,生成您需要的多个令牌(例如

pat-1,pat-2...)。

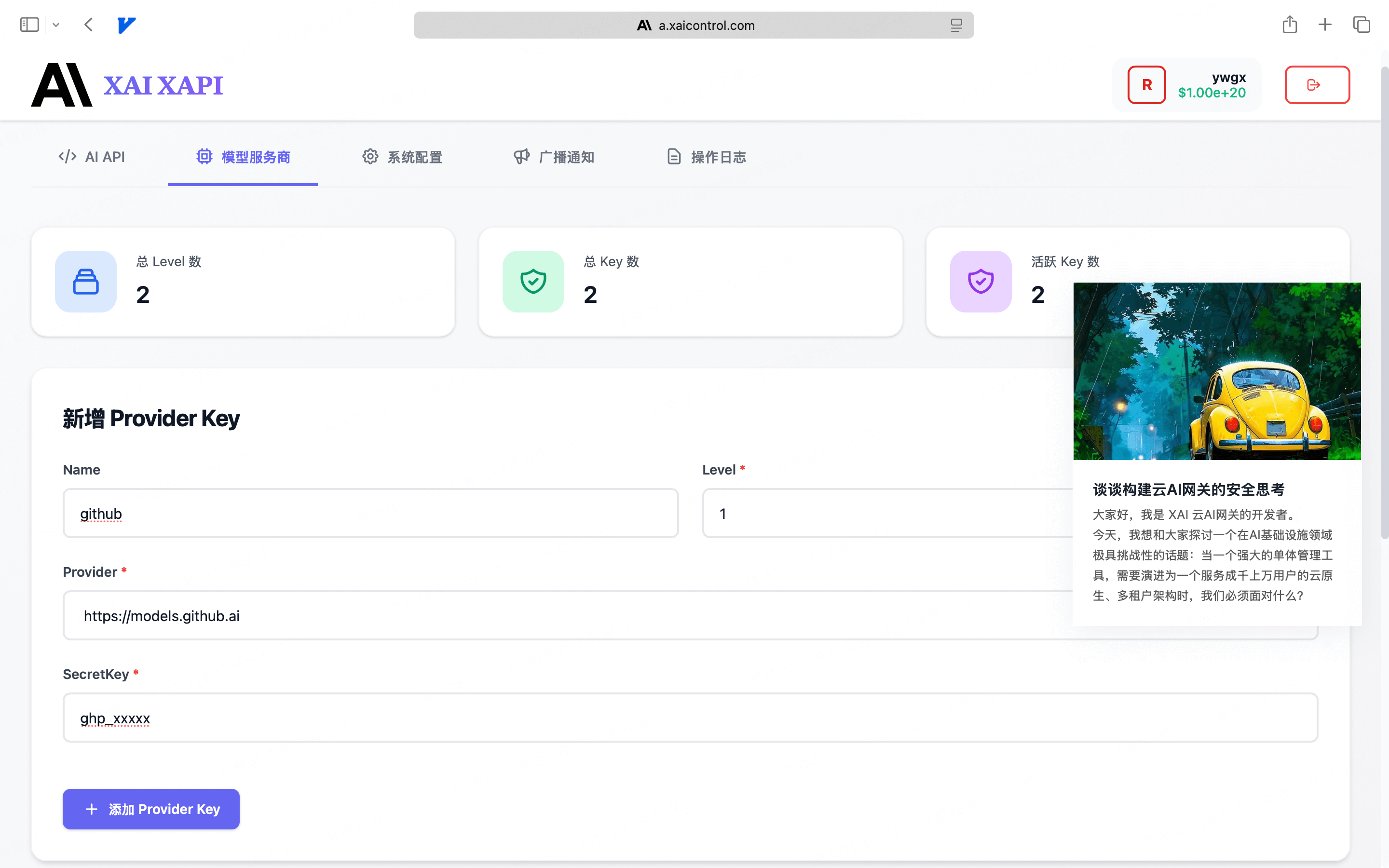

第二步:配置 XAI Control 的负载均衡分组

这是实现所有魔法的核心步骤。我们将利用 XAI Control 的 Level 分组概念来配置负载均衡。

- 登录您的 XAI Control 账户 a.xaicontrol.com。

- 进入 「模型服务商」 → 「新增 Provider Key」。

- 添加第一个密钥,并注意

Level的设置:- Name (可选):

github-key-1 - Level:

1(这是我们的负载均衡分组编号) - Provider:

https://models.github.ai - SecretKey: 粘贴您生成的第一个

ghp_令牌。

- Name (可选):

- 再次点击「新增 Provider Key」,添加第二个密钥,确保

Level值与第一个完全相同:- Name (可选):

github-key-2 - Level:

1(与上一个密钥保持一致,将它们放入同一个组) - Provider:

https://models.github.ai - SecretKey: 粘贴您生成的第二个

ghp_令牌。

- Name (可选):

- 重复此过程,将您所有的 GitHub 令牌都添加到同一个

Level下。

负载均衡与高可用性设计

您刚刚完成的配置,正是 XAI Control 强大调度能力的核心。

- 分组即资源池: XAI Control 的

Level(分组) 定义了一个服务商资源池。一次模型调用请求,会由同一Level下的所有密钥来共同处理。 - 自动轮询与倍增上限: 当您在同一个

Level(例如,都设置为1)下添加了多个密钥时,XAI Router 会自动在这些密钥之间进行轮询调用。这意味着,如果单个 PAT 的 RPM(每分钟请求数)限制为 30,您添加了 3 个 PAT,那么这个Level的总 RPM 理论上就提升到了 90! - 故障自动切换: 如果某个密钥因为达到速率限制或失效而返回错误,XAI Control 会立即将其标记为暂时不可用,并自动重试下一个健康的密钥,整个过程对您的应用透明,从而保证了服务的高可用性。

第三步:开始调用!

所有配置都已就绪。现在,您只需使用您的 XAI API Key(在注册 XAI Control 后邮件中收到的 Key)发起请求即可。

打开您的终端,运行以下命令:

# 将 "你的XAI-API-Key" 替换成你收到的 XAI 密钥

export XAI_API_KEY="你的XAI-API-Key"

curl https://api.xaicontrol.com/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $XAI_API_KEY" \

-d '{

"model": "openai/gpt-4o",

"messages": [

{"role": "user", "content": "请用 Go 语言写一个函数,用于解析 URL 中的查询参数"}

],

"stream": true

}'

当您发起此请求时,XAI Control 会自动从您配置的 Level 1 分组中选择一个健康的密钥进行调用。如果您连续发起多次请求,您会发现流量被均匀地分配到了您添加的所有 GitHub 令牌上,轻松突破了单个密钥的速率限制。

从开发到生产:将企业级 AI 服务商接入负载均衡

GitHub Models 主要适用于原型验证和开发调试场景,其速率和稳定性可能无法满足生产环境的严苛要求。

当您准备将应用推向生产时,您需要的是官方、高可用的 AI 服务。好消息是,您刚刚所有操作,可以无缝地应用到任何企业级 AI 服务商上。

场景示例:为 OpenAI 服务构建高可用资源池

假设您的业务依赖 OpenAI,并且为了提高速率上限和可用性,您购买了多个 API Key。现在,您可以像配置 GitHub Models 一样,将它们配置成一个高可用的资源池。

- 登录您的 XAI Control 账户 a.xaicontrol.com。

- 进入 「模型服务商」 → 「新增 Provider Key」。

- 将您的多个 OpenAI Key 添加到同一个

Level分组中:

| Name (可选) | Level (分组) | Provider (服务商地址) | SecretKey (您的密钥) |

|---|---|---|---|

openai | 10 | https://api.openai.com | sk-proj-xxxx... |

openai | 10 | https://api.openai.com | sk-proj-yyyy... |

openai | 10 | https://api.openai.com | sk-proj-zzzz... |

配置要点:

- 统一

Level:所有用于生产的 OpenAI Key 都被设置在同一个Level(例如10)下,形成一个统一的资源池。 - 统一

Provider:服务商地址统一指向官方的https://api.openai.com。 - 自动调度:当您的应用通过 XAI Control 调用

gpt-4o时,XAI Router 会自动在 Level=10 的密钥间进行负载均衡和故障切换。

通过这种方式,XAI Control 不仅是您管理 GitHub 免费模型的利器,更是您构建高可用、可扩展、统一的生产级 AI 服务架构的核心枢纽。您可以为 OpenAI、Anthropic、DeepSeek、Google Gemini 等任何服务商创建类似的负载均衡池。

第四步 (可选):为团队或客户分配模型访问权限

恭喜!您已经为您的 AI 服务创建了一个高可用的资源池。现在,最重要的一步是如何将这个强大的能力安全、可控地分配给您的团队成员或客户使用。

这正是 XAI Control 子账户体系 的用武之地。

请记住 XAI Control 的两个核心管理后台:

a.xaicontrol.com:资源管理后台,您作为主账户,在这里配置上游 Provider Key(就像您刚才做的那样)。m.xaicontrol.com:账户管理后台,您作为主账户,在这里创建和管理子账户,分配额度与权限。

操作步骤

登录账户管理后台 使用您的主账户邮箱和密码,登录 m.xaicontrol.com。

创建子账户 进入 「创建子账户」 页面,为您的团队成员或客户创建一个新的子账户,并设置一个初始额度。子账户创建成功后,系统会自动将他/她专属的

XAI API Key发送到其邮箱。精细化配置权限 这是最关键的一步。点击 「更新子账户」,您可以对该子账户进行精细化控制:

配置项 说明 针对本场景的配置示例 额度上限 子账户可消耗的最大金额(USD) 50.00模型白名单 极其重要:限制该子账户只能调用您允许的模型。 ["openai/gpt-4o", "xai/grok-3-mini"]

(只允许调用您在 GitHub Models 中配置的那些模型)RPM/TPM 限制 控制该子账户的调用速率,避免滥用。 RPM: 100, TPM:200000IP 白名单 仅允许指定 IP 调用,增强安全性。 ["192.168.1.0/24"]

核心优势

通过这种方式:

- 安全隔离:您的子账户用户使用他们自己的 API Key,完全接触不到您在上游配置的任何 GitHub PAT 或官方 API Key。

- 成本可控:您可以为每个子账户设置独立的额度上限和模型权限,实现精准备成本控制和计费。

- 权限最小化:通过模型白名单,您可以确保子账户只能访问您授权的特定模型,防止越权调用。

现在,您的团队成员或客户就可以使用他们收到的 XAI API Key,像您在第三步中那样,安全、稳定地调用您配置好的 AI 模型资源了,而所有的用量和权限都在您的掌控之中。